Veröffentlicht am: 5. Januar 2026

6 Minuten Lesezeit

Vertrauen in agentische Tools aufbauen: Was wir von unseren Nutzer(inne)n gelernt haben

Entdecke, wie Vertrauen in KI-Agenten durch kleine, positive Mikro-Wendepunkte entsteht, nicht durch große Durchbrüche.

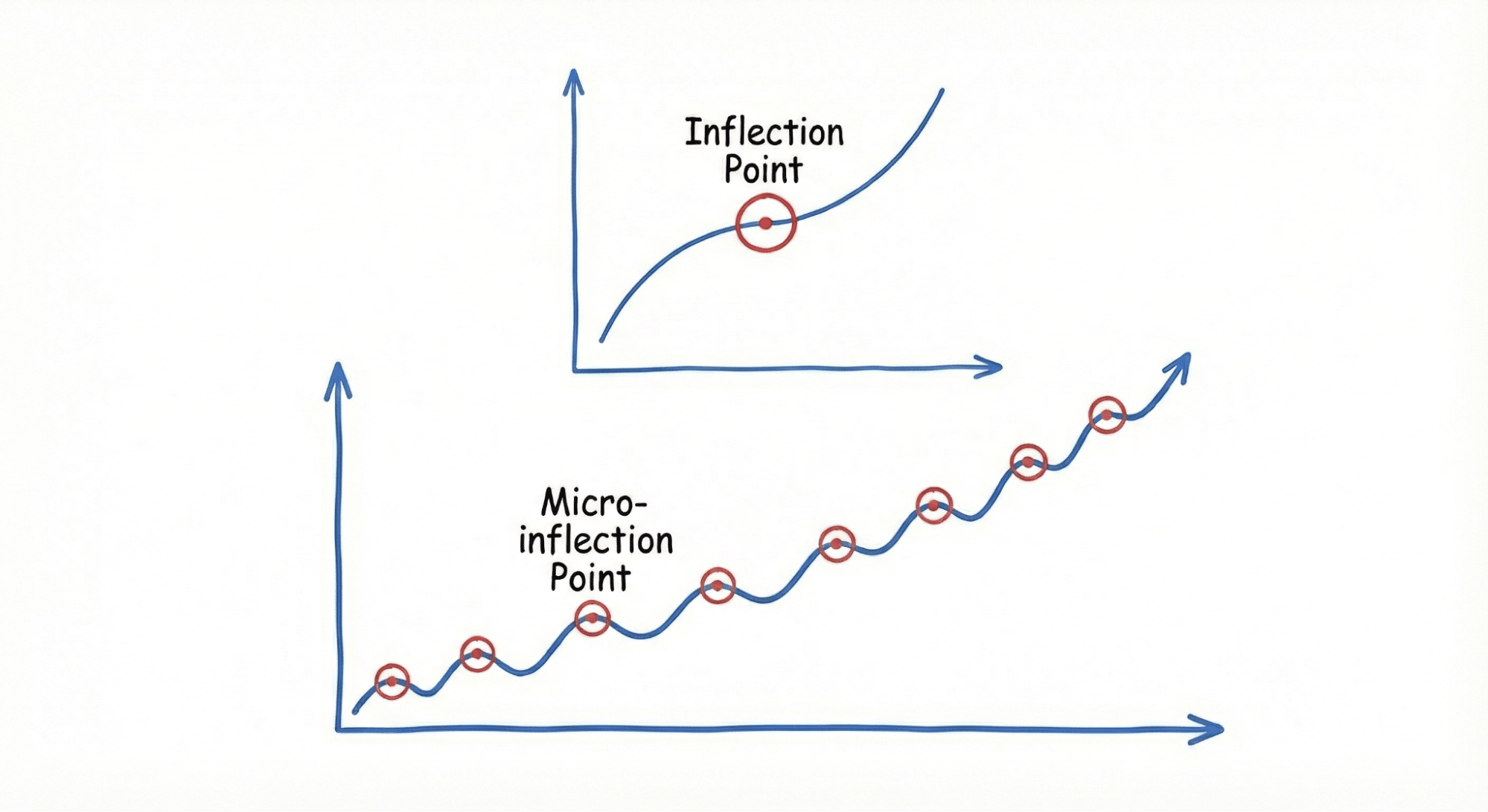

Da KI-Agenten zu immer ausgefeilteren Partnern in der Softwareentwicklung werden, stellt sich eine entscheidende Frage: Wie bauen wir dauerhaftes Vertrauen zwischen Menschen und diesen autonomen Systemen auf? Aktuelle Studien vom UX-Team von GitLab zeigen, dass Vertrauen in KI-Agenten nicht durch dramatische Durchbrüche entsteht, sondern durch unzählige kleine Interaktionen, sogenannte Wendepunkte, die sich im Laufe der Zeit ansammeln und Zuversicht und Zuverlässigkeit schaffen.

Unsere umfassende Studie mit 13 Nutzer(inne)n agentischer Tools aus Unternehmen verschiedener Größen hat gezeigt, dass die Adoption durch "Mikro-Wendepunkte" erfolgt – subtile Designentscheidungen und Interaktionsmuster, die schrittweise das Vertrauen aufbauen, das Entwickler(innen) benötigen, um sich in ihren täglichen Workflows auf KI-Agenten zu verlassen. Diese Erkenntnisse sind entscheidend für Organisationen, die KI-Agenten in ihre DevSecOps-Prozesse einbinden.

Traditionelle Software-Tools verdienen sich Vertrauen durch vorhersehbares Verhalten und konstante Leistung. KI-Agenten hingegen arbeiten mit einem Grad an Autonomie, der Unsicherheit einführt.

Unsere Forschung zeigt, dass Nutzer(innen) sich nicht durch einzelne "Aha"-Momente von KI-Tools begeistern lassen. Stattdessen entwickeln sie Vertrauen durch angesammelte positive Mikro-Interaktionen, die zeigen, dass der Agent ihren Kontext versteht, ihre Leitplanken respektiert und ihre Workflows eher verbessert als stört.

Dieser schrittweise Vertrauensaufbau ist besonders kritisch in DevSecOps-Umgebungen, in denen Fehler Produktionssysteme, Kundendaten und Geschäftsabläufe beeinträchtigen können. Jede kleine Interaktion verstärkt oder untergräbt das Fundament des Vertrauens, das für produktive Mensch-KI-Zusammenarbeit notwendig ist.

Vier Säulen des Vertrauens in KI-Agenten

Unsere Studie identifizierte vier Schlüsselkategorien von Mikro-Wendepunkten, die Nutzervertrauen aufbauen:

Handlungen absichern

Vertrauen beginnt mit Sicherheit. Nutzer(innen) brauchen die Gewissheit, dass KI-Agenten keinen irreversiblen Schaden an ihren Systemen verursachen. Wesentliche Sicherheitsvorkehrungen umfassen:

- Bestätigungsdialoge für kritische Änderungen: Bevor Operationen ausgeführt werden, die Produktionssysteme beeinträchtigen oder Daten löschen könnten, sollten Agenten pausieren und explizite Genehmigung einholen

- Rollback-Möglichkeiten: Nutzer(innen) müssen wissen, dass sie Agentenaktionen rückgängig machen können, wenn etwas schiefgeht

- Sichere Grenzen: Für Organisationen mit Compliance-Anforderungen müssen Agenten Datenresidenz- und Sicherheitsrichtlinien ohne ständige manuelle Aufsicht respektieren

Transparenz bieten

Nutzer(innen) können dem nicht vertrauen, was sie nicht verstehen können. Effektive KI-Agenten wahren Sichtbarkeit durch:

- Echtzeit-Fortschrittsaktualisierungen: Besonders wichtig, wenn Nutzeraufmerksamkeit benötigt werden könnte

- Aktionserklärungen: Vor der Ausführung hochriskanter Operationen sollten Agenten ihren geplanten Ansatz klar kommunizieren

- Klare Fehlerbehandlung: Wenn Probleme auftreten, brauchen Nutzer(innen) sofortige Warnungen mit verständlichen Fehlermeldungen und Wiederherstellungspfaden

Diese Transparenz verwandelt KI-Agenten von mysteriösen Black Boxes in verständliche Partner, deren Logik Nutzer(innen) nachvollziehen und verifizieren können.

Kontext erinnern

Nichts untergräbt Vertrauen schneller, als einem KI-Agenten wiederholt dieselben Informationen beibringen zu müssen. Vertrauensbildende Agenten zeigen Gedächtnis durch:

- Präferenzbeibehaltung: Akzeptieren und Anwenden von Nutzerfeedback über Programmierstile, Deployment-Muster oder Workflow-Präferenzen

- Kontextbewusstsein: Erinnern früherer Anweisungen und projektspezifischer Anforderungen

- Anpassungsfähiges Lernen: Weiterentwicklung basierend auf Nutzerkorrekturen ohne explizite Neuprogrammierung

Unsere Forschungsteilnehmer betonten durchweg die Frustration mit Tools, die sich nicht an grundlegende Präferenzen erinnern konnten und sie zwangen, immer wieder dieselbe Anleitung zu geben.

Bedürfnisse antizipieren

Vertrauen entsteht, wenn KI-Agenten proaktiv die Workflows der Nutzer(innen) unterstützen. Agenten könnten den Nutzer(innen) auf folgende Weise unterstützen:

- Mustererkennung: Nutzerroutinen lernen und Aufgaben basierend auf Tageszeit oder Projektkontext vorhersagen

- Intelligente Agentenauswahl: Automatisch erkennen, welche spezialisierten Agenten für bestimmte Aufgaben am relevantesten sind

- Umgebungsanalyse: Programmierumgebungen, Abhängigkeiten und Projektstrukturen ohne explizite Konfiguration verstehen

Diese antizipierenden Fähigkeiten verwandeln KI-Agenten von reaktiven Tools in proaktive Partner, die die kognitive Belastung reduzieren und Entwicklungsprozesse optimieren.

Vertrauensbildende Funktionen implementieren

Für Organisationen, die KI-Agenten einsetzen, schlägt unsere Forschung mehrere praktische Implementierungen vor:

- Mit risikoarmen Umgebungen beginnen: Ermögliche es Nutzer(inne)n, Vertrauen schrittweise aufzubauen, indem du mit unkritischen Aufgaben beginnst. Wenn das Vertrauen durch positive Mikro-Interaktionen wächst, erweitern Nutzer(innen) natürlich ihre Abhängigkeit von KI-Fähigkeiten.

- Für kontinuierliche Orchestrierung von Agenten designen, die Intervention einschließt: Im Gegensatz zu traditioneller Automatisierung sollten KI-Agenten wissen, wann sie pausieren und menschlichen Input einholen müssen. Diese Intervention versichert den Nutzer(inne)n, dass sie die ultimative Kontrolle behalten, während sie von KI-Effizienz profitieren. Agenten benötigen auch Autonomie-Level-Kontrollen, damit sie die Autonomie für verschiedene Arten von Aktionen in verschiedenen Kontexten kalibrieren können.

- Audit-Trails aufrechterhalten: Jede Agentenaktion sollte nachvollziehbar sein, sodass Nutzer(innen) nicht nur verstehen können, was passiert ist, sondern auch warum der Agent spezifische Entscheidungen getroffen hat.

- Die Erfahrung personalisieren: Agenten, die sich an individuelle Nutzerpräferenzen und Team-Workflows anpassen, schaffen stärkere Vertrauensbindungen als Einheitslösungen.

Der zusammengesetzte Einfluss von Vertrauen

Unsere Studie zeigt, dass Vertrauen in KI-Agenten einem zusammengesetzten Wachstumsmuster folgt. Jede positive Mikro-Interaktion macht Nutzer(innen) etwas mehr bereit, sich für die nächste Aufgabe auf den Agenten zu verlassen. Im Laufe der Zeit erwächst aus diesen kleinen Erfahrungen großes Vetrauen, das KI-Agenten von experimentellen Tools in unverzichtbare Entwicklungspartner verwandelt.

Dieser Vertrauensaufbauprozess ist heikel – ein einzelner bedeutender Fehler kann Wochen angesammelten Vertrauens auslöschen. Deshalb ist Konsistenz in diesen Mikro-Wendepunkten entscheidend. Jede Interaktion zählt.

Die Unterstützung dieser Mikro-Wendepunkte ist ein Eckpfeiler dafür, dass Software-Teams und ihre KI-Agenten unternehmensweit mit intelligenter Orchestrierung zusammenarbeiten.

Nächste Schritte

Vertrauen in KI-Agenten aufzubauen erfordert durchdachtes Design, das auf Nutzerbedürfnisse und -bedenken fokussiert ist.

Organisationen, die agentische Tools implementieren, sollten:

- Ihre KI-Agenten auf vertrauensbildende Mikro-Interaktionen prüfen

- Transparenz und Nutzerkontrolle im Agentendesign priorisieren

- In Gedächtnis- und Lernfähigkeiten investieren, die negative Interaktionen reduzieren

- Klare Eskalationspfade schaffen für Situationen, in denen Agenten auf Unsicherheit stoßen

Wichtige Erkenntnisse

- Vertrauen in KI-Agenten baut sich schrittweise durch Mikro-Wendepunkte auf, nicht durch gewaltige Durchbrüche

- Vier Schlüsselkategorien treiben Vertrauen an: Handlungen absichern, Transparenz bieten, Kontext erinnern und Bedürfnisse antizipieren

- Kleine Designentscheidungen in KI-Interaktionen haben zusammengesetzte Effekte auf Nutzeradoption und langfristige Abhängigkeit

- Organisationen müssen absichtlich für Vertrauen durch konsistente, positive Mikro-Interaktionen designen

Sag uns, was dir wichtig ist: Deine Erfahrungen sind unschätzbar wertvoll bei unserer Gestaltung von agentischen Interaktionen. Tritt unserem Forschungspanel bei, um an kommenden Studien teilzunehmen.

Erkunde GitLabs Agenten in Aktion: Die GitLab Duo Agent Platform erweitert die Geschwindigkeit von KI über das reine Programmieren hinaus auf deinen gesamten Software-Lebenszyklus. Mit deinen Workflows, die die Regeln definieren, deinem Kontext, der organisatorisches Wissen aufrechterhält, und deinen Leitplanken, die Kontrolle sicherstellen, können Teams orchestrieren, während Agenten über den SDLC hinweg ausführen. Besuche die GitLab Duo Agent Platform Seite, um zu entdecken, wie intelligente Orchestrierung deine DevSecOps-Reise transformieren kann.

Egal ob du Agenten zum ersten Mal erkundest oder deine bestehenden Implementierungen optimieren möchtest, wir glauben, dass das Verstehen und Designen für Vertrauen der Schlüssel zu erfolgreicher Adoption ist. Lass uns diese Zukunft gemeinsam aufbauen!

Feedback erwünscht

Dieser Blogbeitrag hat gefallen oder es gibt Fragen oder Feedback? Ein neues Diskussionsthema im GitLab-Community-Forum erstellen und Eindrücke austauschen.

Feedback teilen